In questo periodo di Green Pass il termine campione, nell’accezione statistica del termine, è finito sulla bocca di tutti. Il campione corretto per la P.A. è stato stabilito nel 20% e per tutti la dimensione ottimale del campione è divenuto il 20% della popolazione, nel senso statistico del termine. A ben guardare, in statistica un campione del 20% è un campione enorme.

Puntiamo l’attenzione sull’importanza e la validità di piccoli o piccolissimi campioni, per rendere le misurazioni meno complesse e meno onerose sia in termini di tempi che risorse economiche.

Le analisi del rischio possono essere qualitative o quantitative. Quest’ultime spesso sono poco utilizzate per la difficoltà di reperire dati. La soluzione più semplice è misurare o meglio campionare.

Vediamo insieme alcuni metodi di misurazione con piccoli campioni.

Indice degli argomenti

Rilevanza statistica

Citeremo velocemente alcuni concetti di statistica, per risolvere alcune obiezioni che emergeranno leggendo questo articolo. Così facendo rinfrescheremo la memoria su alcuni concetti necessari, se si vuole misurare qualcosa e ancor di più, se si vuole fare un‘analisi del rischio quantitativa.

Dai nostri ricordi di Statistica emerge sempre chiara e forte la convinzione, che più o meno un campione deve essere grande per essere rilevante e significativo (es. il 20%). In realtà questo è un fraintendimento bello e grosso.

A livello di promemoria in statistica la popolazione è l’insieme degli elementi oggetto di osservazione mentre il campionamento è la porzione o sezione, che verificheremo.

“La rilevanza statistica aiuta a quantificare se un risultato è casuale o se è stato condizionato da qualche fattore che lo ha influenzato”[1]. In sintesi, un campionamento è significativo se ben rappresenta l’intera popolazione e non è falsato o influenzato da errori.

Ovviamente più grande è il campione e minore è l’incidenza dell’errore. Ecco perché nei nostri nebulosi ricordi è persistente la convinzione che il campione debba essere grande per essere significativo.

Facendo un esempio, se necessito di sapere se la “policy della scrivania pulita” è applicata nella mia organizzazione posso fare un censimento o posso optare per un campionamento. Se il mio studio è composto da 15 persone in presenza, basterà a fine giornata lavorativa censire, verificando le 15 scrivanie. Se la mia organizzazione è una multinazionale dislocata su 12 sedi in diversi paesi, con un tasso medio del 22% di collaboratori in smart working, per un totale di 1.282 dipendenti, il censimento potrebbe essere scomodo, oneroso e time consuming. Ovviamente, più ampio sarà il campione, maggiore sarà il nostro senso di comfort ma con esso crescerà anche il costo del campionamento, costringendoci a fare i conti con il budget a disposizione.

E quindi, quale dovrebbe essere la dimensione del campione perché questi sia rilevante? Come vedremo, anche campioni piccoli possono essere significativi o ben rappresentativi.

Varianza della popolazione

La varianza è un altro elemento importante da ricordare. La varianza è il valore di omogeneità della popolazione. Più è omogenea e minore sarà la probabilità o l’impatto di un possibile errore, più è eterogena e maggiore sarà il rischio di avere valori falsati. In pratica se il fenomeno che necessitiamo di misurare è estremamente omogeneo (es. se un italiano maschio è tifoso di una squadra di calcio), anche un campionamento di una manciata di persone sarà abbastanza veritiero e rappresentativo dell’intera popolazione.

Maggiore è la varianza nella popolazione sottostante e quindi la sua eterogeneità, maggiore sarà la possibilità che vi sia un errore di campionamento. Se necessitiamo di verificare la probabilità, che un attacco di social engineering vada a segno, se la nostra popolazione fosse molto eterogenea per scolarizzazione, competenze, estrazione, un piccolo campionamento sarà più suscettibile di errore.

Un esempio facile da comprendere e con i quali, vista la loro mediaticità, abbiamo spesso a che fare sono i sondaggi politici, dove la popolazione italiana avente diritto di voto è di 46 milioni, con ampia eterogeneità culturale, economica, sociale, territoriale e una significativa disgregazione partitica. Il campione dovrà essere quindi importante. Solitamente nei sondaggi politici la dimensione del campione oscilla fra i 3.000 e i 5.000 intervistati. Si noti che tale campione in proporzione è estremamente piccolo e pari allo 0,0001087 della popolazione sottostante (5.000/46mln), ben lontani dal 20%.

Per assurdo, tenendo buono questo rapporto di campionatura, nell’esempio dell’organizzazione con 1.282 dipendenti ne intervisteremmo meno di 1 (1282*0,0001087=0,13).

Questo solo per sottolineare che la dimensione del campione deve essere contestualizzata alla dimensione e alla eterogeneità della popolazione sottostante, e che un campione presunto grande (5.000 intervistati) in realtà potrebbe essere significativamente piccolo.

Campionamenti con piccoli numeri

Tornando a noi, il nostro obiettivo è passare da un’analisi del rischio qualitativa, e quindi soggettiva e priva di misurazioni, a una quantitativa fatta di misurazioni.

Il problema è che in fase di transizione fra un metodo e l’altro si è sostanzialmente privi di misurazioni e la principale obiezione, che spesso ci si sente dire è: “Non ho dati da misurare!”

Questa obiezione purtroppo è bloccante e ci pone in un circolo vizioso, poiché se la mancanza di dati impedisce di iniziare una misurazione, il non iniziare una misurazione avrà come naturale conseguenza quella di non avere mai dati. Dichiarare di voler implementare un’analisi quantitativa senza far lo sforzo di cercare i dati, potrebbe assomigliare a certi buoni propositi sciorinati durante il veglione di San Silvestro.

In un precedente articolo dal titolo: “Rischio e misurazione quantitativa: dove recuperare i dati” abbiamo descritto una serie di strumenti e “luoghi” dove recuperare dei primi dati grezzi, imperfetti ma funzionali, ottimi per iniziare il processo di misurazione.

Preme ricordare che l’obiettivo è ridurre l’incertezza e non certo avere una misurazione perfetta. Se una misurazione imperfetta riduce l’incertezza, l’obiettivo sarà abbondantemente raggiunto, disinnescando il nostro circolo vizioso, migliorando la nostra analisi che sarà più oggettiva di una qualsiasi stima qualitativa soggettiva, avviando un percorso di graduale miglioramento delle misurazioni, che col tempo si arricchirà di serie storiche e dati stratificati.

Il problema come in molte altre situazioni è iniziare. Se il “come misurare” è stato ben illustrato nell’articolo poc’anzi citato, il “quanto misurare” proviamo a definirlo nel prosieguo.

N= 1, un singolo campione

“La regola della maggioranza del campione singolo, formalmente dice: Data la massima incertezza su una popolazione, tale da far credere che il fenomeno investigato possa essere qualsiasi cosa tra 0% e 100%, con tutti i valori ugualmente probabili, abbiamo un 75% di possibilità che un singolo campione selezionato a caso provenga dalla maggioranza della popolazione”[4].

Questa affermazione potrebbe sembrare sconvolgente e in effetti lo è. Se la popolazione sottostante è binaria, ho solo due popolazioni di cui non conosco la proporzione, una qualsiasi scelta casuale di un singolo campione, ha il 75% di probabilità di ricadere nella popolazione maggioritaria.

Se la mia incertezza è massima (non conosco e non ho alcuna indicazione della distribuzione della popolazione), anche un singolo campionamento migliorerà di molto la mia incertezza del fenomeno.

Questo curioso fenomeno chiamato anche “urn of mystery” non vuole essere un’indicazione operativa, ma una semplice suggestione per segnalare che anche la più piccola campionatura ha un certo valore informativo, anche se limitarsi a un singolo campione per un’analisi del rischio quantitativa, non è consigliabile.

PS: scettico sulla sua reale efficacia, ho testato il suo funzionamento con una simulazione Monte Carlo e ha funzionato.

N= 5, un campionamento di soli 5 campioni

“C’è una probabilità del 93,75% che la mediana di una popolazione sia compresa tra il valore più piccolo e quello più grande di un qualsiasi campione casuale di cinque elementi dalla popolazione”.

Immaginiamo di avere un qualsiasi problema di misurazione e di non avere budget o tempo per fare una misurazione approfondita. Ad esempio, dobbiamo misurare l’impatto economico di un ransomware, che colpisca la nostra organizzazione. Per il momento trascuriamo gli aspetti correlati all’evento, quali ad esempio possibili sanzioni o danni d’immagine, e ci concentriamo sull’entità del riscatto in bitcoin che potrebbe esserci richiesto.

Prendere un dato medio già elaborato da qualche ente, che si occupa di monitoraggio del fenomeno, non ci convince, essendo questi calcolato su tutti gli attacchi avvenuti in Italia senza prendere in considerazione la dimensione dell’organizzazione colpita o il suo settore di appartenenza. Cosa facciamo: raccogliamo tutti i dati di tutti i data breach in Italia e li segmentiamo per tipologia di attacco, settore e dimensione dell’organizzazione colpita? Il gioco probabilmente non varrebbe la candela.

Supponiamo invece di scegliere un campione di 5 ransomware, che hanno colpito realtà omogene o analoghe alla nostra. Il valore dei riscatti richiesti è in milioni 0,5 – 0,8 – 1,0 – 1,5,- 2,0. La mediana del campionamento è 1, ossia il valore al centro, ma questo non ci interessa particolarmente. A noi interessa la mediana dell’intera popolazione, i ransomware che hanno colpito realtà omogene o analoghe alla nostra.

Secondo la regola del 5 si ha il 93,75% delle probabilità, che la mediana di tutti i riscatti dell’intera popolazione ricada fra 0,5 e 2 milioni.

Come si spiega questo fenomeno?

La possibilità di selezionare casualmente un valore al di sopra della mediana è, per definizione, del 50%; pari alla probabilità di scivolare da un lato o dall’altro di un tetto, se stiamo camminando sul suo colmo o la stessa che esca testa se lanci una monetina. La possibilità di selezionare casualmente cinque valori, che si trovino tutti al di sopra della mediana è come lanciare una moneta e ottenere testa cinque volte di seguito, ossia 1 su 32, che equivale a una probabilità di 3,125%. Quindi la probabilità di non avere 5 lanci consecutivi con il medesimo risultato è (100% – 3,125% * 2) il 93,75%.

La mediana dell’intera popolazione dunque non può essere fuori dal nostro campionamento, perché equivarrebbe a dire che ho avuto 5 campioni consecutivi sopra o sotto la mediana. Questa affermazione è identica a dire che ho avuto 5 teste o 5 croce lanciando 5 volte la mia monetina.

N≤ 30, un campionamento con meno di 30 campioni

Secondo lo stesso meccanismo del campionamento da 5 campioni, possiamo applicare il medesimo approccio a campionamenti leggermente più grandi.

Non entrerò nel dettaglio del calcolo o della regola, così come per utilizzare un software o un foglio excel non necessitiamo di capire il meccanismo alla base del suo funzionamento, ci limiteremo a comprenderne la sua applicabilità al nostro problema di misurazione.

Se volessimo alzare il campionamento da 5 a 8, non prenderemo in esame tutti e 8 i valori ma quelli compresi fra i secondi valori estremi (secondo e penultimo). Nell’ipotesi vista poc’anzi dei ransomware, allarghiamo la ricerca individuando altre 3 richieste di riscatto di valore 1,2 – 2,7 e 2,2 milioni. Avremo quindi un campione di 8 elementi (0,5 – 0,8 – 1,0 – 1,2 – 1,5 – 2,0 – 2,2 – 2,7) e la probabilità del 93% che la mediana sia compresa fra 0,8 e 2,2.

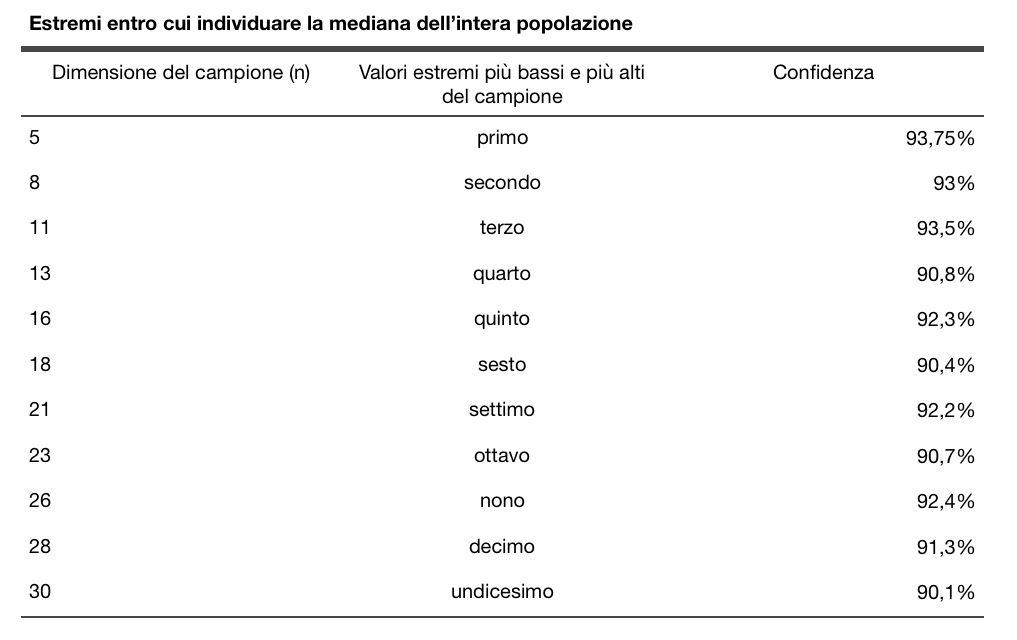

Se volessimo allargare ulteriormente il campionamento osserviamo la tabella sotto, dove a sinistra abbiamo la dimensione del campione, al centro gli estremi da prendere in considerazione e a destra la confidenza espressa dal campionamento.

T-statistic e birra

Nei primi anni del ventesimo secolo a Dublino nel noto birrificio Guinnes, tale W. S. Gosset aveva un problema di misurazione. Aveva bisogno di un metodo per misurare quali tipi di orzo producevano le migliori rese di produzione della birra. Gosset non poteva permettersi campionature numerose, necessitava di un calcolo statistico che funzionasse con campionamenti piccoli.

Nel 1908, Gosset sviluppò un nuovo calcolo statistico ma Guinnes gli impedì di pubblicarlo, poiché non voleva far sapere ai competitor che assumeva esperti di analisi dei dati e di statistica, cercando di tutelare questo suo significativo vantaggio competitivo. Gosset pubblicò allora il suo metodo nascondendosi dietro l’anonimato e lo chiamò “t-statistic”.

La t-statistic offre la possibilità di calcolare intervalli di confidenza del 90% con campionamenti piccoli e nello specifico formati da soli 2, 3, 4, 5, 6, 8, 12, 16 oppure 28 campioni.

Non ci addentreremo nella spiegazione del metodo o della formula, basterà googolare nel caso si volesse approfondirla, poiché lo scopo dell’articolo è riflettere sul sorprendente valore informativo di piccoli campionamenti, più che esplicare tutti i possibili metodi di calcolo.

Misura ciò che vedi

Esiste una tecnica di campionamento chiamata Mark-Recapture o Capture-Recapture.

L’esempio classico, utilizzato per spiegare questa tecnica, è quella del conteggio dei pesci all’interno di un lago. Il censimento prevedrebbe di pescare tutta la popolazione ittica per poi ributtarla in acqua al termine del conteggio. Ciò ovviamente avrebbe costi enormi.

La tecnica Mark-Recapture prevede l’esecuzione di un primo campionamento (pesca non invasiva di un quantitativo definito) e la marcatura dei pesci raccolti (con un pigmento indelebile), che verranno reintrodotti nel lago. A distanza di qualche giorno prevede un secondo campionamento, all’interno del quale vi sarà anche qualcuno dei pesci precedentemente marcati.

Fondamentalmente, questo metodo è semplicemente l’esecuzione di due campionamenti indipendenti, in cui confrontiamo la sovrapposizione tra i due campioni, per stimare la dimensione della popolazione.

Se nel nostro esempio il primo campione era di 1.000 pesci e il secondo di 1.200 con 50 marcature, la popolazione complessiva del lago sarà di 24.000 pesci. Si calcola il rapporto fra pesci marcati e dimensione del secondo campione (50/1200=0,04166667) poi si divide il primo campione per il coefficiente calcolato (1000/0,04166667 = 24.000).

Questa misurazione non è perfetta, essendo una stima della popolazione ma è scientificamente convalidata, e soprattutto migliora di molto la comprensione del fenomeno offrendo un valore prossimo alla dimensione effettiva della popolazione.

Se volessimo stimare il numero di errori nello sviluppo di un software particolarmente complesso, potremmo utilizzare due diversi team di verifica. Quindi confronteremmo le risultanze e applicheremmo il calcolo sopra riportato.

Conclusioni

Che sia un campione composto da un singolo rilevamento, da 5, da 30 o anche un numero più alto ma proporzionalmente piccolo rispetto all’intera popolazione, appaiono pur sempre campionamenti privi di rilevanza statistica per la maggior parte delle persone. Ma la matematica non si sbaglia su questi metodi.

A volte abbiamo un pregiudizio sul fatto che un campione debba essere una percentuale significativa dell’intera popolazione ma, se questo fosse un requisito, nessuna misurazione in biologia o fisica sarebbe lontanamente possibile, poiché le dimensioni della popolazione sono spesso, e letteralmente, astronomiche.

Per apprezzare l’effetto di questi piccoli campioni, è importante ricordare quanto poco sapevamo prima del campionamento. Se l’incertezza è massima, anche una piccola misurazione è bastevole per migliorarla; e se lo scopo della misurazione è la riduzione di tale incertezza allora possiamo dirci soddisfatti anche con un piccolo campione.

Note

- T.C. Redman autore di “Data Driven: Profiting from Your Most Important Business Asset” ↑

- D. Hubbards autore del libro “How to measure anything” ↑